本文旨在提供一份简洁、高效的Kontext LoRA(炼丹)训练指南。我们将摒弃冗长的理论,直击核心,帮助您掌握这项强大的“技能学习”技术。

一、基础概念

二、训练逻辑

1.输入与噪声化:将训练集中的图像输入模型,并像标准的扩散过程一样添加噪声。

(把图片变成马赛克等进行“毁掉”)

目的:对AI说:看,我把这张图弄花了,你能不能把它变回原来的样子?

——————————–

2.比较与去噪:模型利用其基础权重和当前的LoRA适配器权重,对噪声图像进行去噪。

(交由AI使用基础大模型恢复原来模样)

目的:让AI利用现有条件(我们提供的基础大模型和适配器)进行恢复原样

——————————–

3.计算损失:将模型去噪后的输出与未加噪声的原始图像进行比较,计算两者之间的差异。这个差异值即为“损失”,它量化了模型当前表现与理想目标之间的差距。

(对比恢复的效果如何)

目的:看看能恢复成什么效果,对比和观察效果

——————————–

4.权重更新:通过反向传播算法,根据损失值来调整LoRA适配器矩阵A和B的权重,目标是使损失值最小化。

(修改效果的不足)

目的:调整LoRA那个“小笔记本”里的内容,使其更好。

——————————–

5.迭代优化:重复以上步骤,通过成千上万次的迭代,LoRA权重会逐渐学习到如何引导基础模型生成符合训练集特征(如特定人物、风格或物体)的图像 。

(反复重复以上逻辑训练)

目的:通过成千上万次的“练习-订正-再练习”,让产出的LoRA更“听话”。

——————————–

总结:本质上就是一个“AI恢复大赛”。我们不断地把好图弄坏,让AI去恢复,恢复不好就告诉它错在哪,让它下次恢复得更好。重复几千次后,AI就成了一个顶级的恢复专家,掌握了从“坏”到“好”的这个“技能”。当使用这个LoRA的时候就会重复它所学习到的技能。

这种方法的优越性显而易见:最终生成的LoRA文件只包含这些经过训练的、小型的适配器权重,其体积通常只有几兆到几百兆字节,远小于动辄数GB的完整模型。这使得LoRA模型的存储、分发和加载都极为高效。

三、训练重点

数据集的质量是决定LoRA模型成败的最关键因素,其重要性甚至超过参数调优。一个精心策划的数据集是模型学习正确、泛化能力强的概念的基础。

- 图片集:

一个由20至60张甚至更多的高质量、清晰、主题突出的图像组成的小型数据集,其训练效果往往远超一个包含数百张质量参差不齐、充满噪声图像的大型数据集 。 - 高分辨率与清晰度:

图像应尽可能清晰,避免模糊、失焦或带有压缩噪点。建议使用不低于1024×1024像素的图像 。 - 主题突出:

训练主体(人物、物体或风格元素)应在图像中清晰可见,占据主要位置。 - 多样性:

为了让模型具备良好的泛化能力,数据集必须包含多样化的样本。

例如,训练一个人物LoRA,应收集该人物在不同角度、不同光照条件、不同表情、不同姿势甚至不同服装下的照片,那么出来的效果就又更宽泛的可能性 。如果所有训练图都是同一角度的正面照,那么生成的图像也很可能被限制在这个角度。

但是又例如:在平衡的两端就是两种结果。如果只收集该人物比较固定的角度,人脸,服饰,那么出来的效果即是围绕在这个训练集上进行简单变化,也就是实现了同一人物的“人物一致性”。

四、硬件要求:训练的基石

Kontext LoRA的训练,尤其是在高分辨率下,对显存(VRAM)有极高要求。

-

白银标准:4090 24GB显存(VRAM) -

黄金标准:4090 48GB显存(VRAM) -

钻石标准:L40S 48G显存(VRAM)

若本地硬件不足,可租用云GPU服务是极具性价比的选择。

https://www.gpufree.cn/home

我看中了“算力自由”的L40S/48G的显卡,速度快,价格也是比较合理的。各位可根据自身的炼丹需求选择显卡。

重点:48G显存才是核心,不管是4090D,4090,还是L40S,都大差不差,但是如果没有选用48G显存,很容易就会爆显存,无法训练。

五、炼丹炉选择

AI-Toolkit

这是由一位在AI社区非常知名的开发者Ostris(也被称为Ostris AI)创建和维护的 。这个项目是开源的,代码托管在GitHub上,任何人都可以下载和使用 。

这是一个功能强大且高度可定制的软件工具包,专门用于训练AI模型,特别是用于图像生成的LoRA模型 。也就成了我们俗称的“炼丹炉”。

支持本地和云端部署:

本地:如果您的电脑有足够强大的显卡(通常建议24GB或更多显存),您可以在自己的机器上运行它进行训练 。

云端:如果本地硬件不足,可以在云GPU服务上租用一台高性能计算机,然后在其上运行“ai-toolkit”来完成训练 。有些云服务器已经部署了该炼丹炉,可以直接使用,无需再自己进行部署。

管理训练数据:它要求用户按照特定的文件夹结构来组织训练图片和标注文件(例如,Kontext训练需要control和dataset两个文件夹),这有助于保持训练流程的规范和高效。

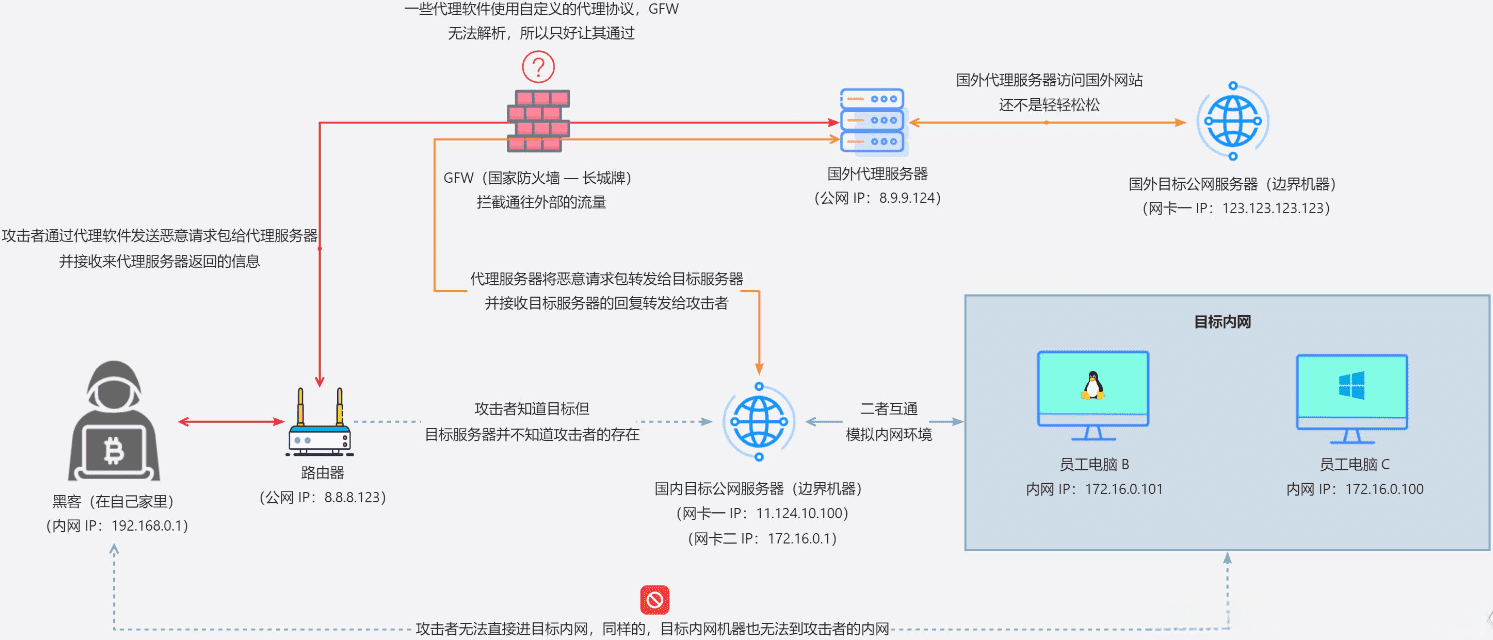

六、核心机制:从“学习概念”到“学习技能”

Kontext LoRA与标准LoRA最根本的区别,就是在于学习的输入、

- 标准LoRA (基于FLUX.1-dev)

学习一个静态概念。您提供一组关于“某物”的图片,模型学习“它是什么”。 - Kontext LoRA (基于FLUX.1-Kontext-dev)

学习一个动态过程或编辑动作。提供“编辑前”和“编辑后”的成对图像,模型学习“如何做” 以及表达出“这就是我要你实现的效果”

3种结果

- 欠拟合 (Underfitting)

:模型还没学会,效果不够好。 - 拟合良好 (Well-fitted)

:模型学会了技能,并且具备泛化能力,来什么图片都能应付。 - 过拟合 (Overfitting)

:模型学得“太过了”,成了死记硬背训练集里的图片变化,只能应付跟训练集相似度高的图片。

七、素材准备:成对图像是唯一法则

Kontext LoRA的训练效果90%取决于数据集的质量。

-

所有图片都应是高分辨率(推荐1024×1024)、清晰无噪点的PNG格式。 -

并且必须是“成双成对”(“编辑前”与“编辑后”图像 ) - 文件夹结构:

通常需要两个文件夹,例如control(存放“编辑前”图像)和dataset(存放“编辑后”图像),内部文件名需一一对应 。

八、标注的艺术:从“描述”到“指令”

注意:经过不同版本的演变,目前Kontext LoRA的标注占比更大的是指令,而非描述。

- 核心策略

为所有图像对使用完全相同的、高度概括的“大师指令” 。这会迫使模型学习该指令背后通用的、抽象的“技能”,而不是60个零散的具体操作。 - 触发词

虽然到Kontext这一代可以不用使用触发词,但是最好还是标注一个独特的触发词来在最终使用时激活LoRA。 - 打标词:

使用专用的图推词工具进行基础打标,如果Joy Caption3,Florence2。个人建议:无需采用很强很全面的模型,因为在kontext里更多是“指令词”而非“描述词”,简单的描述图片内容即可,过多的词汇反而可能干扰AI的执行。

九、 推荐训练参数:任务配置

AI-Toolkit操作界面

- Training Name:

LoRA名称(设置名称,最好英文) - Model Architecture:

模型架构(FLUX.1-Kontext-dev) - Linear Rank:

网络秩数值:8-64(其他地方有叫Dim值或者Network Rank) - Data Type:

模型型号选择:BF16/FP16 - Save Every:

X步,则保存一个LoRA(250/1000) - Max Step Saves to keep:

对应上方的保存几个LoRA - Trigger Word:

触发词,记得要英文逗号结尾 - Steps:

总步数:图片对数量 × 150/(3000+) - Dataset:

编辑前图像文件夹:remover_controls - Control Dataset:

编辑后图像文件夹:remover_images - Default Caption:

默认指令

右上角Create Job,开始执行。

其他通常可保持不动,亦或者根据不同LoRA需求,进行调整

详细解释

Model Architecture(使用模型)

使用FLUX.1-Kontext-dev。

Data Type(使用模型)

型号通常选用BF16即可。也有FP16,不建议FP32,虽然FP32精度高,但是速度缓慢是前者时间的双倍,而提升的精度和效果微乎其微。

Resolutions(图像大小)

以往是512,也不是不行,但如果为了更好的质量,并且通常都是租GPU的情况下,完全可以采用1024×1024的尺寸!

Linear Rank(网络秩)

也就是Flux炼丹炉里面的Dim值。

-

决定了LoRA适配器矩阵的大小,直接影响LoRA模型的复杂度和文件大小。 -

数值高,能学习更复杂的细节,并且文件会更大, -

数值小,模型更小,训练更快,更不容易过拟合,但可能无法捕捉所有细节。

推荐值:对于人物或风格,Rank在8到64之间都是常见选择。32是一个很好的平衡点 。

Steps (训练步数)

默认是3000步,也可以更高,有个公式是:图片对数量 × 100/150

Save Every(每几步保存一个模型)

上面提到,如果训练步数过多会拟合过度,也就是死记硬背,照本宣科,无法应对不一样的图片,所以可以设置多几个模型。

比方说:3000步,每250步保存一个lora,保存4个lora。那意味着保存第5个250步的lora的时候,第一个保存的lora就会被删除,以此类推到最后结束,给到你4个lora。

可根据自己的把握,经验,效果调整步数。

十、实战案例:珠宝精修LoRA完整流程

1.目标

训练一个能自动对珠宝图片进行去瑕疵、提亮、优化光影的LoRA。

2.具体做法

准备好同一份图片,两份素材集:一份布满瑕疵的珠宝产品的图片。一份精修完美的珠宝产品图片。提交给到AI。

3.底层逻辑

看!本身是这样的瑕疵品,产品表面杂乱,材质瑕疵很大。看!这是修好的效果,产品表面干净,材质正确。你要按照这种结果学习和呈现。

4.素材准备 (核心步骤):

-

准备30-60张不同种类、材质和角度的珠宝白底图片,我原本准备了60张,但是后面发现有3张不是很优秀,选择素材时应该保持宁缺毋滥的心态,一定要挑选极好的素材。所以最后保持57张。同时这个数量已经是完全足够的了。

编辑前(修前):置入remover_controls文件夹

编辑后(修后):置入remover_images文件夹

-

确保所有图片均为1024×1024,png格式 -

并对其进行顺序严格的命名 -

分为前面提到的两个部分:编辑前(修前)和编辑后(修后) -

素材来源思路为:从AI获取精美精修图,再由AI进行“脏图”改造,也就是故意让精美的图片变脏,由此得出前后效果图。 -

按照训练器要求,将“编辑前”的图片放入remover_controls文件夹,将“编辑后”的图片放入remover_images文件夹,并确保文件名一一对应。

5.标注

对图片进行打标

方法一:工作流打标

红色框:位于input文件夹里的输入文件夹路径,可自行设置该文件夹

蓝色框:图推词节点和模型,为Joy Caption3。也可以采用其他图推词模型

黄色框:指令词汇,意为:(进行专业的珠宝修饰,增强光泽,清洁所有表面,并保持产品组合完好无损。将其转化为一张完美无瑕、具有影棚灯光效果的商业照片。应用电商产品拍摄优化处理:分离主体,打磨金属,)注意,需要以英文逗号结尾

棕色框:把指令词和图像词一起输入结合,根据文本1和文本2为顺序。先指令词,再图像表述词。

紫色框:Python表达式:a+b+c。a为触发词,b为文本联结一同输入的主词,c为结尾统一词。触发词可在炼丹炉里加,所以触发词和结尾统一词,我没有对其连接。

青色框:保存的输出路径:某文件夹内。文件名:自定。后缀名:选择txt

最后输出的效果如下:必须与前面的图片命名一致,否则会出错

方法二:使用某些炼丹炉作者做好的图片打标工具

使用某些炼丹炉旁自带的图片打标工具

6.上传

6.1本地端路径

编辑前(修前)的路径为:remover_controls

编辑后(修后)的路径为:remover_images。并跟打标词放置在一起,图片和.txt命名要两两相对。这样才能被识别到。

6.2云端炼丹炉

命名两个:remover_controls、remover_images

7.参数设置

训练参数调节

- Training Name:

Jewelry Refining - Model Architecture:

FLUX.1-Kontext-dev - Linear Rank:

64 - Data Type:

BF16 - Save Every:

1000 - Max Step Saves to keep:

10 - Trigger Word:

字母+英文逗号,如XM, - Steps:5000

- Dataset:

编辑前图像文件夹,选择remover_controls - Control Dataset:

编辑后图像文件夹,选择remover_images

设置完毕,右上角开始运行

8.LoRA测试

等训练完毕,便会看到6个LoRA的出现,这个时候便可以拿到ComfyUI测试效果了

把6个lora拉入到工作流里进行测试,使用同一张图,所有的设置都一样,检验六个哪个会欠拟合,哪个拟合良好,哪个过拟合。我设置了10个LoRA测试,只用到了训练出来的6个。提示词就写炼丹时候的:“指令词”+对产品的简单描述。

9.效果展示

原图,正常的产品不会如此瑕疵和斑驳遍布,我只是稍微加强一下瑕疵,试图让AI修复能量更强,更能应付更多的珠宝精修。

总结:

1.要达真人级别精修不是不行,需要看产品

2.需要优化素材集,比方说我的编辑前瑕疵给的过于夸张,所以这个LoRA的能力将是,瑕疵越大,效果越好,当瑕疵平平无奇的时候,作用就被削弱了

3.如果有微瑕到精修的素材集做对比,那么效果将会很强

4.对于珠宝精修的数值会区别于其他,需要非常精致且细致的密度效果,甚至于可以将Linear Rank值提高到128,我设置64, 步数6000步,属于略微保守的数值,欢迎各位各抒己见!

十一、内容拓展

珠宝精修和产品精修,其实原理是一样的,或者说,整个kontext原理都差不多,都是前后对比图。

再给各位分享一下,其他效果的LoRA可以怎么做

1.质感增强器

核心思路:教会模型提升图像的整体质感、细节和清晰度,改善基础模型可能出现的“塑料感”或模糊感。

素材准备

- remover_images (处理后 – 目标)

:收集20-50张认为质感极佳的图像。这些图片可以来源于Midjourney等以画质细腻著称的模型,或者经过专业锐化和细节增强处理的照片。数据集应包含人物、动物、风景、材质特写等多种类别,以增强通用性。 - remover_controls (处理前 – 起点)

:将上述每一张“高质感”图,通过FLUX或SDXL基础模型进行一次低强度的重绘,或者在Photoshop里经典操作,Ctrl+T放大缩小几次,造成模糊。这样生成的图片会保留构图但质感会“退化”,从而创造出完美的对比组。

Linear Rank:32-64

Save Every:500-1000

Max Step Saves:保存的数量=总步数Steps ÷ 每x步Save Every

Steps:图片数量x100步

2.场景/产品打光

核心思路:教会模型对已有图像进行光影重塑,将其从普通光照变为具有特定风格的专业商业布光效果。

素材准备

- remover_controls (处理前 – 起点)

:准备一批在均匀、柔和、无明显风格的光照下拍摄的人物或产品照片。 - remover_images (处理后 – 目标)

:为上述每张图片创造出具有理想光效的“目标图”。在Photoshop进行修图打光的效果。

Linear Rank:64

Save Every:500-1000

Max Step Saves:保存的数量=总步数Steps ÷ 每x步Save Every

Steps:图片数量x100步

写在最后

总是一个测试下来的感受是这样的,对于一些特定的产品,实打实是有用的。有些效果不佳,要改善的点就是要更精准表达给AI:我要你干什么。

通过前后对比图也好,通过提示词打标也好,加强参数的设置也行,当然最重要的还是我们的素材图要精准要准确!

建议是可以缩小使用范围,精准修饰,例如银器→微瑕→注重光影,以此路径进行深造,打造专一的产品线,集合大批量的不同种类的银器→微瑕为编辑前。强劲的光影和精品的精修效果图为编辑后,以此做强对比输入给AI,让其反复且深入训练出银器微瑕的LoRA,兴许能有意想不到的收获!